多機能化に向かう次世代カメラ:コンピュテーショナルフォトグラフィの活用で (1/5 ページ)

コンピュテーショナルフォトグラフィと呼ばれる技術分野に注目が集まっている。従来のカメラの撮像過程を変更し、シーンの単なるスナップショット画像以上の情報をイメージセンサーで取り込み、デジタル信号処理と組み合わせることで、従来のカメラでは不可能な「写真」を撮影しようという試みだ。本稿では、この分野の重要な一角を占め、撮影後の写真のピント変更を可能にするなど、多様な応用が期待できるライトフィールドの概念を用いた技術について説明する。

撮像過程の変革

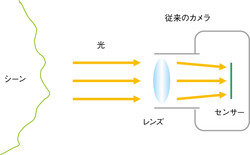

カメラの機能の多くは、デジタル化が実現されても、依然としてアナログカメラのアナロジーであり続けている。すなわち、シーンから入射する光をカメラのレンズによって屈折/集光し、2次元の画像として記録するという撮像の本質は変わっていない(図1)。画素数を増やすだけでは製品の差異化が難しくなってきた昨今、カメラメーカー各社は、差異化の別の軸として、デジタル画像処理を駆使した高機能化を追求している。

そうした画像処理を利用した機能は、顔認識に代表されるように、アナログカメラでは確かに実現できなかったことには違いない。しかし、その画像処理は、従来の撮像過程を経た画像に対して適用されるのであり、撮像過程そのものは依然としてアナログカメラのそれのままである。

デジタル化によって得られるメリットをさらに有効に活用し、アナログカメラでは不可能な撮像の世界を切り開くためには、撮影後の処理だけでなく、撮像過程そのものも合わせて変わっていく必要がある。すでにアカデミックな世界では、コンピュテーショナルフォトグラフィ(Computational Photography:計算写真学)と呼ばれる研究分野の動きが盛んになっている。

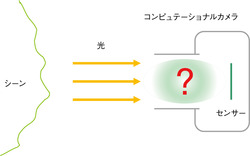

まだ立ち上がり始めた段階にあることから、コンピュテーショナルフォトグラフィの定義はあいまいで、広義には画像処理による写真の後処理や編集のことも含んで語られることがある。しかし、狭義には、カメラの撮像系を変更して、シーンの単なるスナップショットとしての画像以外に、奥行きや物体の反射特性などといった情報をもイメージセンサーを通してデータとして記録し、計算によってその情報を復元することを指している。

光を利用してシーンの情報をイメージセンサーから取り込むという点は従来のカメラと同じだが、主に光学部品(時に機械部品)により撮像過程が改変されたものによって得られる“写真”は、必ずしも人間がそのまま見て意味のあるものであるとは限らない。しかし、そのデータからは、画像処理(信号処理と呼んだほうがイメージがわくかもしれない)によって意味のある情報を取り出すことができる。これが「コンピュテーショナル」と呼ばれるゆえんである。また、そのためのカメラを「コンピュテーショナルカメラ」と呼ぶ(図2)。コンピュテーショナルフォトグラフィ技術により、カメラは多様な情報収集装置となり得るのだ。

また、それらの情報を使うことによって、従来のアナログカメラでは不可能な撮像が可能になる。例えば、ある形態のコンピュテーショナルカメラを利用すれば、撮影後にピントの変更が可能な“写真”を撮影することができるといった具合である(後述)。

急速に発展し、すでに多くの技術が発明されているコンピュテーショナルフォトグラフィ分野の全貌を本稿で説明するのは、紙幅の都合上、難しい(興味のある読者は参考文献*1)などを参照されたい)。そこで本稿では、この分野の重要な一角を占め、多くのコンピュテーショナルフォトグラフィ技術の基礎となっている「ライトフィールド(Light Field:光線空間)」*2)、*3)の概念に焦点を絞り、その撮影法と応用技術について解説する。

ライトフィールド

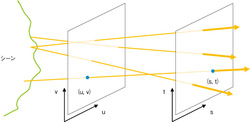

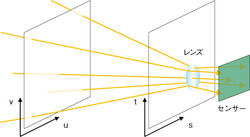

ライトフィールドは、遮蔽物のない空間を飛び交う光線の「場」である(図3)。1本1本の光線は、その光線に沿うようにシーン中の点から発せられた(または反射された)光の輝度を保持している。ライトフィールド中の1本の光線を特定するには、例えば図3に示すようなかたちで2つの平行な平面を適当に設定し、各平面と光線との交点(s, t)、(u, v)を指定すればよい。4つのパラメータによって光線が1つ特定できることからわかるように、ライトフィールドは4次元データである。

■カメラとの関係

シーンからカメラに向かってくる光線群は、ライトフィールドだと考えることができる。ここでは、従来のカメラがこの4次元ライトフィールドからどのようにして2次元の画像を取得するのかを説明しておこう。

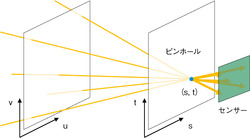

まず、ピンホールカメラについて考える。この場合、カメラはライトフィールドの(s, t)座標を固定した1点から見た(u, v)平面(2次元)を記録していることになる(図4)。逆に言えば、ライトフィールドとは、ピンホールカメラを(s, t)平面上で2次元で動かしながら多数の画像を撮影した多視点画像であると考えることもできる。

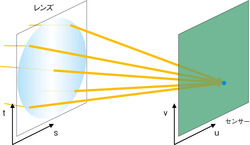

次に、一定の大きさのレンズを備える通常のカメラを考える。この場合、カメラは(s, t)平面上のある領域を通ってくるライトフィールドを観測していることになる(図5)。2次元画像は、レンズによって屈折した光線群が集光されて記録された結果である。

レンズによる屈折効果を省いて、4次元のライトフィールドが2次元の画像になる過程をより直感的に理解するには、カメラ内のライトフィールドについて考えるとよい(図6)。議論を簡素化するために、ここでは、イメージセンサーとカメラのレンズの後端部にライトフィールドを規定する2つの平面を置くものとしよう。イメージセンサーの各画素(u, v)は、レンズのあらゆる点を通ってそれぞれの画素に入射する光線の合計の光量を記録する。つまり、レンズ面(s, t)に対して4次元のライトフィールドを合計(積分)した結果、次元が4から2に落ちているのだと考えることができる。

この積分の過程では、2次元分の情報を捨てることになる。そのため、1枚の画像からライトフィールドの4次元データを復元するのは原理的に不可能である(シーンに対する何らかの強い仮定が必要)。逆に、ライトフィールドのデータがあれば、従来のカメラでは光学的に行われている積分の処理を信号処理によって行うことにより、2次元画像を得ることができる。

脚注

※1…R. Raskar, J. Tumblin, A. Mohan, A. Agrawal, Y. Li. Computational photography. Proc. Eurographics STAR, 2006

※2…M. Levoy, P. Hanrahan. Light field rendering. Proc. ACM SIGGRAPH 96, pp.31〜42, 1996

※3…S. J. Gortler, R. Grzeszczuk, R. Szeliski, M. Cohen. The Lumigraph. Proc. ACM SIGGRAPH 96, pp.43〜54, 1996

Copyright © ITmedia, Inc. All Rights Reserved.